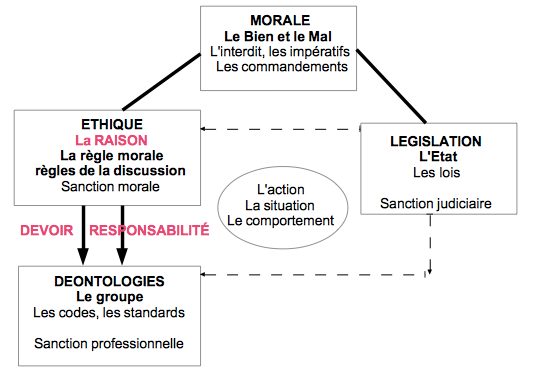

Schéma

Définition des principaux concepts

L’approche de l’éthique déontologique met en avant la rationalité: définir les règles importantes que l’on a le devoir de respecter pour vivre ensemble. Cette éthique de la raison, soutenue par E. Kant au XVIIIe siècle, s’est opposée à l’éthique de l’utilitarisme et à l’éthique de la vertu personnelle:

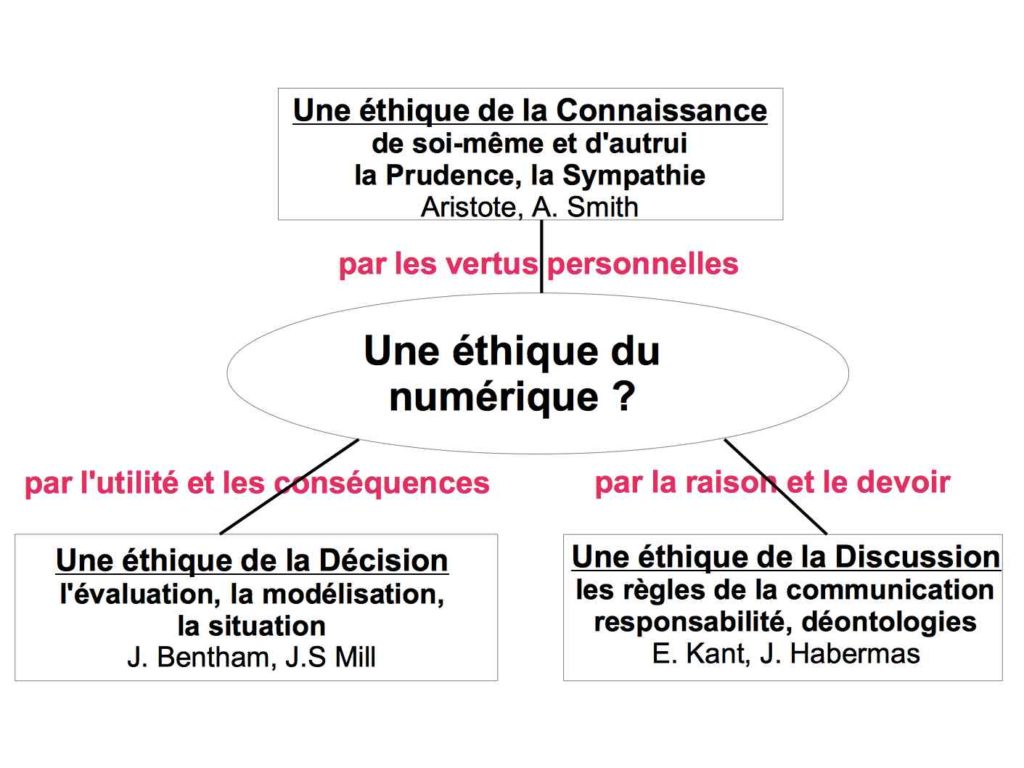

Ici la question théorique devient: Peut-on définir une éthique du numérique qui serait fondée sur la raison et sur la définition des règles à observer?

- pour Emmanuel Kant il s’agit d’un impératif moral catégorique pour pouvoir vivre en société (1);

- pour Jürgen Habermas il s’agit aujourd’hui des normes de discussion pour pouvoir vivre en démocratie délibérative (2);

- dans une éthique numérique (et puisqu’une technologie n’a pas d’impératif moral en elle-même) la valeur morale peut venir d’une véritable discussion éthique des règles, des règles de conception et des règles d’usage (3).

1. L’éthique du devoir moral impératif, selon E. Kant

Que dois-je faire impérativement? Voulant se libérer des considérations sur la vertu (liées à la culture, à la religion ou à la personnalité), la réponse de Kant se fonde sur la raison et la rationalité (voir Fondements de la métaphysique des mœurs, section 2 Wikisource). On peut alors découvrir deux types d’impératifs qui poussent à agir:

- des impératifs dépendants des circonstances ou d’exigences pragmatiques (si je dois gagner de l’argent, si je dois trouver un emploi…);

- et des impératifs de type moral, qui s’appliquent en eux-mêmes, sans réserves, au-delà des inclinations personnelles (justice, égalité, vérité…).

Mais au final, Kant démontre qu’il ne peut y avoir qu’un seul véritable impératif moral catégorique, indépendant des conséquences et du désir humain, auquel toutes les maximes d’action plus spécifiques doivent se conformer: « Agis toujours d’après une maxime telle que tu puisses vouloir qu’elle soit une loi universelle »

Cet impératif est universel, il s’applique à tout le monde. Mais comme tout le monde doit pouvoir l’appliquer, il est aussi basé sur le souci des autres, d’où la seconde formulation: « Agis de telle sorte que tu traites toujours l’humanité, dans ta personne comme dans la personne d’autrui, comme une fin et que tu ne t’en serves jamais comme d’un moyen».

L’éthique de Kant est donc celle d’un agent individuel qui respecte rationnellement des impératifs qui s’appliquent à tous; elle s’accorde bien avec les idées de devoir, mais aussi de responsabilité envers les autres car la fin ne justifie jamais les moyens. Il ne s’agit pas de juger l’action en fonction des conséquences (même s’il va de soi qu’il serait de notre devoir de réparer des dommages faits à autrui) mais bien en fonction des intentions: la valeur morale d’une action ne réside ni dans son but ni dans son mobile, mais dans la volonté d’accomplir l’action en respectant la loi morale située au-dessus de tout, c’est-à-dire conformément au devoir.

Kant admet que ces principes du « monde raisonnable » peuvent être difficiles dans le monde réel, mais un individu doit rechercher sa liberté véritable, et celle-ci réside justement dans la plus grande indépendance possible à l’égard des causes du « monde sensible ». Une controverse fameuse a fait couler beaucoup d’encre (voir Lequan 2004): peut-on avoir le droit de mentir à certaines personnes ? Jamais, répond Kant, en répondant à l’avance au dilemme: est-ce un droit de mentir à la Gestapo, pour tenter de sauver les juifs cachés au dernier étage ?

Kant est inflexible, car le mensonge mettrait en jeu la possibilité de faire société: il est impossible de concevoir des exceptions rationnelles à l’exigence de vérité dans le monde « intelligible », sinon « «je contribue […] à ce que plus personne ne prête foi aux déclarations en général, et ainsi à ce que tous les droits fondés sur des contrats s’écroulent et soient vidés de leur force ; ce qui est un tort à l’humanité en général», Kant 1787, Wikisource). Kant peut seulement accepter d’être pragmatique a posteriori, en disant que dans le monde « sensible » le mensonge ou d’autres formes de désobéissance à la loi morale trouvent des justifications qui en atténueront la gravité.

2. L’éthique de l’Agir communicationnel, selon J. Habermas

Que dois-je respecter dans la communication ? Jürgen Habermas est un philosophe d’aujourd’hui, il a vécu le rêve brisé des utopies de la Modernité et du progrès, mais il refuse le relativisme des Post-modernes. La « pensée critique » qu’il développe (voir Habermas 1992) veut renouveler l’idéal de la Raison dans les sociétés démocratiques, où les individus peuvent constater qu’ils partagent au moins quelque chose: le fait de pouvoir vivre dans une sorte de communauté d’interprétations (voir la Théorie de l’Agir communicationnel).

Une démocratie délibérative repose alors sur une éthique de la communication au moyen d’un ensemble de règles: sur une rationalité personnelle dans la communication et sur une procédure éthique dans la discussion (voir Pesqueux 2015):

- un individu est « rationnel en communication » s’il peut justifier son comportement dans une communication transparente (la parole, par opposition à la novlangue) avec quatre types de « critères de validité » : validité par la clarté d’un discours intelligible, par la vérité d’une logique des énoncés, par la justesse vis à vis de la communauté sociale et par la sincérité des expériences vécues (voir F. Rowe 2009 et voir l’analyse de J. Mingers et G. Walsham 2010);

- les procédures de la discussion sont éthiques si un accord justifié et sans contrainte se réalise sur les normes de l’échange, une déontologie procédurale: principes de délibération, volonté de s’accorder sur un consensus provisoire, et garantie de pouvoir rediscuter ultérieurement (voir Duchamp et Koehl 2008 et voir l’analyse de L. Jaffro 2001).

Au final, on peut même dire que le caractère moral d’une règle ou d’un comportement dépend ici du caractère de leur discussion. Pour J. Habermas en effet « les résultats d’une telle discussion éthique peuvent alors se prévaloir pour eux-mêmes de la présomption de rationalité. Ainsi la perspective de l’éthique de la discussion ouvre des possibilités de rattachements empiriques et sociologiques aux considérations normatives » (voir Habermas 1992). Un exemple peut être donné avec les règles de fonctionnement de la discussion sur Wikipédia (voir Fallery et Rodhain 2013).

.

3. Une éthique du numérique, aujourd’hui fondée des règles déontologiques ? Pour une éthique de la DISCUSSION

Une éthique du numérique en réseau a la particularité de concerner des situations contradictoires (conflits, déviances, dilemmes, paradoxes…) associant le comportement des individus (l’action numérique est toujours une forme « d’écriture », dont la trace est enregistrée, Rosati 2012, et donc contrôlée, Eynard 2012) et le comportement de technologies numériques (comportement, parce qu’elles sont devenues ambivalentes et autonomes, dès leur conception).

Si on adopte alors les principes de l’éthique déontologique, la priorité ne serait pas de commencer par le développement de la vertu personnelle ou par des évaluations des conséquences, mais de commencer par définir « des règles sur les règles », c’est à dire les règles de la discussion (dans des « arènes de choix collectifs » pour Ostrom 1990, ou dans des « forums hybrides » pour Callon et al. 2011, voir cette note de lecture) à chacun des niveaux où doivent s’élaborer des règles de conduites (comités d’éthique et déclarations, règlements européens et nationaux, consortium techniques, ONG et associations, entreprises et organisations, mouvements de salariés…).

Dans une éthique déontologique (et puisqu’une technologie n’a pas d’impératif moral en elle-même)

la valeur morale peut venir d’une véritable discussion éthique des règles de conception en amont et des règles d’usage en aval

a) Une éthique déontologique EN AMONT, dès la conception des technologies numériques?

Même en admettant que les technologies aujourd’hui en réseau n’ont pas d’impératif moral intrinsèque, il faut quand même considérer qu’elles sont toujours ambivalentes dès leur conception; elles sont à la fois un remède et un poison : un Pharmakon pour reprendre l’analyse de B. Stiegler (2007), entre une addiction à l’innovation transgressive et une destruction des équilibres de la société. C’est cette ambivalence qui devrait être le cœur de la discussion éthique sur les règles, en amont, au plus près de la conception.

Mais la littérature académique ou professionnelle sur une éventuelle déontologie de la conception ne fait le plus souvent que :

- soit recenser les nombreuses situations « remède/poison » qui apparaissent : vie privée/Internet des objets, anonymat/Tracking, choix/manipulation, prédiction/discrimination, accès/surveillance, droit/robots, « immatériel »/énergie…

- soit présenter des codes de conduites à respecter, déontologies professionnelles créés par des « experts responsables » : codes Green IT et chartes Responsabilité sociétale dans les entreprises, serment des Data Scientist, serment Holberton-Turing), alliance Allistene, déclaration de Montréal pour l’IA responsable … et même Facebook (!) avec l’Institute for Ethics in AI. Le philosophe T. Metzinger, qui a participé en 2019 aux règles européennes Ethics Guidelines for Trustworthy AI, parle même de blanchiment éthique (ethics washing)

Pourtant c’était bien une éthique de la discussion qui avait fondé la conception d’Internet (Fallery et Rodhain 2013) avec un rôle actif de toutes les « parties prenantes », et pourtant les solutions de co-conception éthiques existent bien aujourd’hui: Society in the loop, GeniAl, Privacy-by-design, un assez ambigu Ethics by design, ou un très précis Toolkit d’éthique algorithmique…

Mais les rapports de force sont si déséquilibrés en faveur des GAFAM et des complexes militaro-industriels, que ce n’est pas l’éthique mais la législation qui semble devoir reprendre la main, face à un semblant d’approche déontologique du devoir qui a ici perdu la confiance nécessaire : de la soft law du « moment libéral » (Pesqueux 2007)… à un retour vers la hard law et des sanctions judiciaires. Voir par exemple la bataille des cookies qui s’engage en 2022 en Europe avec l’étude de cas Google Analytics, voir l’avancement des travaux du Parlement et de la Commission européenne : sur le Digital Service Act pour la modération des services en ligne et sur le Artificial Intelligence Act pour réguler les produits et services embarquant des systèmes d’IA.

b) Une éthique déontologique EN AVAL, dans la discussion des usages numériques ?

Même en admettant que les technologies numériques n’ont pas d’impératif moral intrinsèque, il faut quand même considérer que dans l’usage elles sont devenues autonomes, d’une part parce qu’elles peuvent être elles-mêmes inventives ou auto-régulées (voir Intelligence artificielle et décision) et d’autre part parce qu’elles sont malléables et génératives (on peut s’y greffer, les amender, les compléter, les contourner… de manière optionnelle et réversible, voir la thèse de L. Sarr 2015).

Dans une approche déontologique et une éthique de la discussion il devrait alors s’agir de débattre de cette autonomie des technologies, vis-à-vis des normes et des règles de conduite à respecter en aval… mais bien au delà d’une trop facile « responsabilité des utilisateurs ».

La liste des situations conflictuelles d’usage devient en effet impressionnante et diversifiée : liberté d’expression, hyper-connexion, confidentialité, données personnelles, « captologie » dans une économie de l’attention, propriété intellectuelle, fausses nouvelles, harcèlement, cybercriminalité, piratage, objets connectés, reconnaissance faciale, chatbots et agents intelligents, véhicules autonomes, e-santé, énergie et empreinte carbone… Une éthique des usages du numérique en réseau ne peut donc plus être considérée comme une simple « éthique professionnelle » appliquée : voir, sous l’égide du CIGREF, une intéressante analyse de F. Fischer (2014) sur le passage d’une éthique de l’informatique à une éthique du numérique.

Une distinction théorique pourrait alors être faite sur la base de la Gouvernance polycentrique par l‘action sur les règles, développée par E. Ostrom (1990):

- une discussion des « règles constitutionnelles » dans des arènes de choix sociétaux, telles qu’elles existent par exemple pour la bioéthique : voir depuis 2019 le Comité pilote d’éthique du numérique sur l’égide du Comité national d’éthique CCNE ;

- une discussion des « règles collectives » dans des arènes de choix de pilotage, qui peuvent être communautaires et/ou règlementaires, par exemple : les débats comme ceux de la Commission nationale du débat public, les conférences citoyennes comme celle de la Convention citoyenne pour le climat, les consultations publiques comme celle de la Haute Autorité de Santé….

- une discussion des « règles opérationnelles » dans des arènes de choix plus locales, tendant vers l’auto-organisation : bien sûr au niveau des entreprises ou organisations, mais aussi des associations (Fing, Quadrature du Net…) et des mouvements de salariés (et E. Ostrom note bien qu’il est rare qu’une seule arène de choix soit associée à un seul ensemble de règles: la stratégie clé des individus auto-organisés consiste à aller et venir entre les trois différents niveaux de règles, voir ici l’exemple de Frances Haugen dans l’affaire des Facebook Files).

Au final on pourrait alors parler d’une éthique communicationnelle, suivant les trois grandes dimensions de la communication : la transmission, l’échange et la construction de sens (voir la carte générale des théories en management des S.I.).

.

Voir les autres théories de l’éthique : éthique utilitariste et éthique de la vertu personnelle

Voir les autres théories utilisées dans le contrôle des SI

RÉFÉRENCES

E. Kant (1785), Fondements de la métaphysique des mœurs, trad. 1848 (et voir ici la traduction des œuvres de Kant en accès libre)

E. Kant (1787), D’un prétendu droit de mentir par humanité, trad. 1855

J. Habermas (1992), L’espace public, 30 ans après. Traduction française, Quaderni, n°18, . pp. 161-191.

E. Ostrom (1990), Governing the Commons, Cambrige University Press

Google.books et Notes de lecture note1, note2

M. Lequan (2004), Existe-t-il un droit de mentir : Actualité de la controverse Kant/Constant. Études, tome 400(2)

F. Rowe (2009), Les approches critiques en Systèmes d’Information : de la sociologie de la domination à l’éthique de l’émancipation, Congrès AIM 2009

J. Mingers, G.Walsham (2010) Towards Ethical Information Systems: The Contributionof Discourse Ethics. MIS Quarterly, 34 (4)

D. Duchamp, J. Koehl (2008), L’éthique de la discussion au service de la performance organisationnelle, Revue internationale de psychosociologie et de gestion des comportements organisationnels, 2008/34 Vol. XIV.

L. Jaffro (2001), Habermas et le sujet de la discussion, Cités, 2001/1 n° 5, p. 71-85,

Y. Pesqueux (2015), J. Habermas et l’Agir communicationnel, document HAL

B. Fallery, F. Rodhain (2013), Gouvernance d’Internet, gouvernance de Wikipedia, Revue Management et Avenir n° 65

M. Rosati (2012), Une éthique appliquée ? Éthique publique vol. 14, n° 2

J. Eynard (2012), L’éthique à l’épreuve des nouvelles particularités et fonctions des informations personnelles, Éthique publique vol. 14, n° 2

B. Stiegler, (2007). Questions de pharmacologie générale. Il n’y a pas de simple pharmakon. Psychotropes, vol. 13(3)

et cet entretien en 2016

F. Fischer (2014), Ethique et numérique, une éthique à inventer? Rapport de mission pour le CIGREF

Y. Pesqueux (2007), Éthique des affaires, développement durable et responsabilité sociale de l’entreprise, une continuité en question. Document de travail, 44 pages

L Sarr (2015), Éthique des technologies et systèmes d’information: usages individuels, positionnement moral des organisations et changements socio-techniques: cas du livre numérique. Thèse Université Paris Descartes